I sensori digitali sono le componenti elettroniche che catturano le immagini e le traducono in dati per essere immagazzinate nella scheda di memoria: costituiscono quindi l’elemento fotosensibile delle fotocamere ed hanno oramai soppiantato i vari tipi di pellicola, almeno nell'utilizzo più diffuso.

Di seguito descriviamo cosa sono questi elementi: si entra in un campo prettamente tecnologico. Per scattare fotografie in modo consapevole non è essenziale conoscerne il funzionamento: anche se la comprensione di come si formino oggi le immagini attraverso l’elettronica può essere utile ed interessante. Riporto alcuni concetti base.

Quando si parla di sensore, si associa subito il valore della risoluzione delle immagini, ossia la capacità di rendere i dettagli: dato che l’immagine è registrata dal sensore, parliamo della sua risoluzione totale, che si misura in milioni di pixel totali (i cosiddetti megapixel o MP).

Per comprendere i fattori che determinano la qualità delle immagini occorre introdurre il concetto di fotosito che è la parte unitaria del sensore (appartiene alla categoria hardware). Il pixel rappresenta un gruppo di dati che descrive le caratteristiche cromatiche del più piccolo dettaglio dell'immagine (appartiene alla categoria software).

Per comprendere i fattori che determinano la qualità delle immagini occorre introdurre il concetto di fotosito che è la parte unitaria del sensore (appartiene alla categoria hardware). Il pixel rappresenta un gruppo di dati che descrive le caratteristiche cromatiche del più piccolo dettaglio dell'immagine (appartiene alla categoria software).

I sensori si dividono in due categorie: CCD (Charge-Coupled Device, dispositivo ad accoppiamento di carica) e CMOS (Complementary Metal Oxide Semiconductor). I processi di fabbricazione dei due sensori sono differenti, così come lo è la disposizione dei circuiti su di essi: si tratta sempre di piastrine piene di fotositi che raccolgono e convolgiano la luce. Nell'articolo Sensori CCD e CMOS approfondiamo le loro caratteristiche.

La luce che colpisce il sensore viene immagazzinata in ogni fotosito come carica elettrica. Da ogni fotone si sviluppa un elettrone, che genera tensione elettrica. La carica elettrica è poi convertita per mezzo di un convertitore analogico – digitale (ADC), in dati digitali.

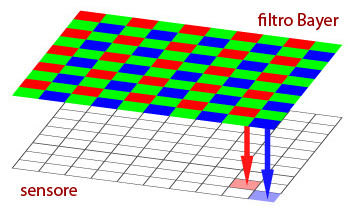

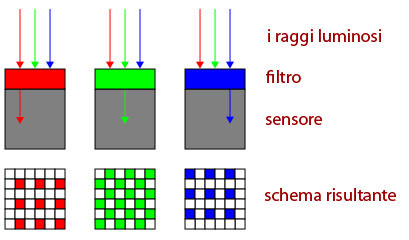

I sensori non hanno alcuna comprensione dei colori della realtà: reagiscono ai fotoni che li investono e loro liberano elettroni, senza essere assolutamente sensibili al colore della luce percepita. Per ottenere il colore viene posto davanti al sensore un filtro a mosaico, con un motivo rosso, verde e blu: in figura si riporta lo schema del filtro di Bayer, il più diffuso.

Il filtro di Bayer è formato da una matrice di punti colorati della stessa dimensione del sensore e con una disposizione ben precisa. Il rapporto sono 2 punti verdi per 1 punto o rosso o blu, perché l’occhio umano è più sensibile al colore verde: è proprio in quella zona dello spettro visibile che riusciamo a riconoscere un numero maggiore di dettagli e di sfumature.

Il filtro di Bayer è formato da una matrice di punti colorati della stessa dimensione del sensore e con una disposizione ben precisa. Il rapporto sono 2 punti verdi per 1 punto o rosso o blu, perché l’occhio umano è più sensibile al colore verde: è proprio in quella zona dello spettro visibile che riusciamo a riconoscere un numero maggiore di dettagli e di sfumature.Quindi la luce attraversa il filtro, colpisce il sensore ed esso registra il valore di luminosità di un solo colore: se levassimo il filtro di Bayer il nostro sensore registrerebbe immagini in bianco e nero.

Per ricostruire tutti i valori RGB (rosso, verde e blu) entra in gioco la demosaicizzazione: un algoritmo che consente di ricostruire, grazie a tecniche di interpolazione, tutti i colori dell’immagine partendo dai dati forniti dal sensore. L’interpolazione bilineare consente di rilevare i valori mancati di canali in un punto, partendo dai punti adiacenti: se nel punto Blu mancano i valori Rosso e Verdi, questi vengono calcolati dai punti adiacenti Rossi e Verdi, attraverso l'interpolazione software dei punti a colori mancanti (e sfruttando quanto più possibile il fatto che i pixel verdi sono in quantità doppia rispetto a quelli rossi e blu).

Per ricostruire tutti i valori RGB (rosso, verde e blu) entra in gioco la demosaicizzazione: un algoritmo che consente di ricostruire, grazie a tecniche di interpolazione, tutti i colori dell’immagine partendo dai dati forniti dal sensore. L’interpolazione bilineare consente di rilevare i valori mancati di canali in un punto, partendo dai punti adiacenti: se nel punto Blu mancano i valori Rosso e Verdi, questi vengono calcolati dai punti adiacenti Rossi e Verdi, attraverso l'interpolazione software dei punti a colori mancanti (e sfruttando quanto più possibile il fatto che i pixel verdi sono in quantità doppia rispetto a quelli rossi e blu).Una delle cose da tenere a mente è che i sensori rispondono alla luce in maniera lineare. Ovvero restituiscono una carica elettrica direttamente proporzionale alla quantità di luce ricevuta: graficamente corrisponde ad una linea retta. Il problema è che il sistema visivo umano è molto più avanzato e “accomodante”: non vediamo sparire improvvisamente le alte luci o le ombre profonde. La nostra risposta, e quella delle pellicole, non è lineare e questo ci permette di vedere i dettagli in una gamma tonale più ampia rispetto a quella del sensore digitale.

Tra l’acquisizione dei dati di un’immagine e il suo immagazzinamento nella scheda di memoria ci sono altri passaggi: ogni produttore usa una particolare tecnologia, finalizzata a correggere gli errori di acquisizione dati ed ottenere il miglior risultato possibile. Un approfondimento sulla tecnologia dei sensori nell'articolo Sensori CCD e CMOS.

Comments powered by CComment